Analyse CRO avec Piano Analytics & Microsoft Clarity

Introduction : qu’est ce que le CRO ?

Le CRO, pour Conversion Rate Optimization, désigne l’ensemble des méthodes visant à améliorer les taux de transformation sur un site ou une application. Il peut s’agir d’augmenter le nombre de demandes de devis, d’inscriptions à une newsletter, de téléchargements ou de ventes, selon les objectifs du parcours.

Optimiser un taux de conversion, ce n’est pas simplement “faire mieux” : c’est comprendre où, pourquoi et comment les utilisateurs quittent un parcours avant d’atteindre l’objectif. Cette démarche repose sur une approche analytique structurée, qui mêle :

- la mesure des comportements utilisateurs, à travers des données de navigation,

- l’analyse des points de friction, visibles dans les parcours ou les contenus,

- et l’identification de leviers concrets d’amélioration, à tester ou corriger.

Dans cet article, nous proposons une méthode complète pour mener une analyse CRO à partir d’un funnel de génération de leads en plusieurs étapes. Objectif : montrer comment passer d’un simple constat de “chute de conversion” à une analyse approfondie, qui combine quantitatif et qualitatif, et surtout, qui débouche sur des recommandations concrètes d’optimisation.

💡 Pourquoi c’est un enjeu ?

- Améliorer le taux de conversion constitue un levier direct de performance pour les dispositifs digitaux. Dans un contexte où les coûts d’acquisition augmentent et où les parcours utilisateurs se complexifient, optimiser l’existant devient une priorité.

- Identifier précisément les étapes d’un funnel qui génèrent de la déperdition permet d’orienter les efforts d’optimisation de manière ciblée. À défaut, les décisions d’ajustement reposent sur des intuitions ou des signaux partiels, au risque de détourner les ressources des véritables points de blocage.

- La mise en œuvre d’une démarche CRO outillée répond à cet enjeu : elle permet d’objectiver les zones de friction, de croiser les données comportementales et contextuelles, et d’isoler les leviers d’amélioration à fort impact.

Cas d’usage : analyse d’un formulaire de demande de devis multi-étapes avec les outils Piano Analytics et Microsoft Clarity

Cadrage de l’analyse : périmètre, funnel et hypothèses

L’étude porte sur un parcours de conversion type « demande de devis » accessible depuis un site B2B. Ce formulaire se structure en quatre étapes successives plus l’étape finale : confirmation de la demande.

Un plan de marquage avancé a été implémenté sur ce parcours. Il permet d’identifier l’affichage de chaque étape, la validation finale du formulaire et de remonter les variables indiquées par l’utilisateur.

L’ensemble des données est collecté via un data layer structuré, puis envoyé dans Piano Analytics, ce qui permet une lecture complète du funnel et une analyse comportementale segmentée.

L’objectif de l’étude est double :

- Mesurer les performances de chaque étape (taux de passage, abandon),

-

Identifier les leviers d’optimisation prioritaires, à travers une

série de questions structurantes :

- Quels sont les taux de transformation par étape ?

- Où se situent les principaux points de rupture ?

- Peut-on isoler des profils ou segments plus concernés par ces abandons ?

- Ces comportements révèlent-ils une friction UX ou une inadéquation offre/besoin ?

Analyse du funnel dans Piano Analytics

Piano Analytics permet d’analyser un parcours de conversion via plusieurs approches : rapport d’exploration d’événements avec filtres, croisements de segments sur métriques dans les rapports data query, ou encore visualisations sur-mesure via les boards.

Dans ce cas, nous avons privilégié l’usage de la feature native “Funnel”, qui offre une lecture directe et consolidée des taux de passage entre étapes.

Le funnel a été construit à partir des événements d’affichage remontés à chaque écran du formulaire. Cette configuration permet de suivre précisément la progression des utilisateurs, étape par étape.

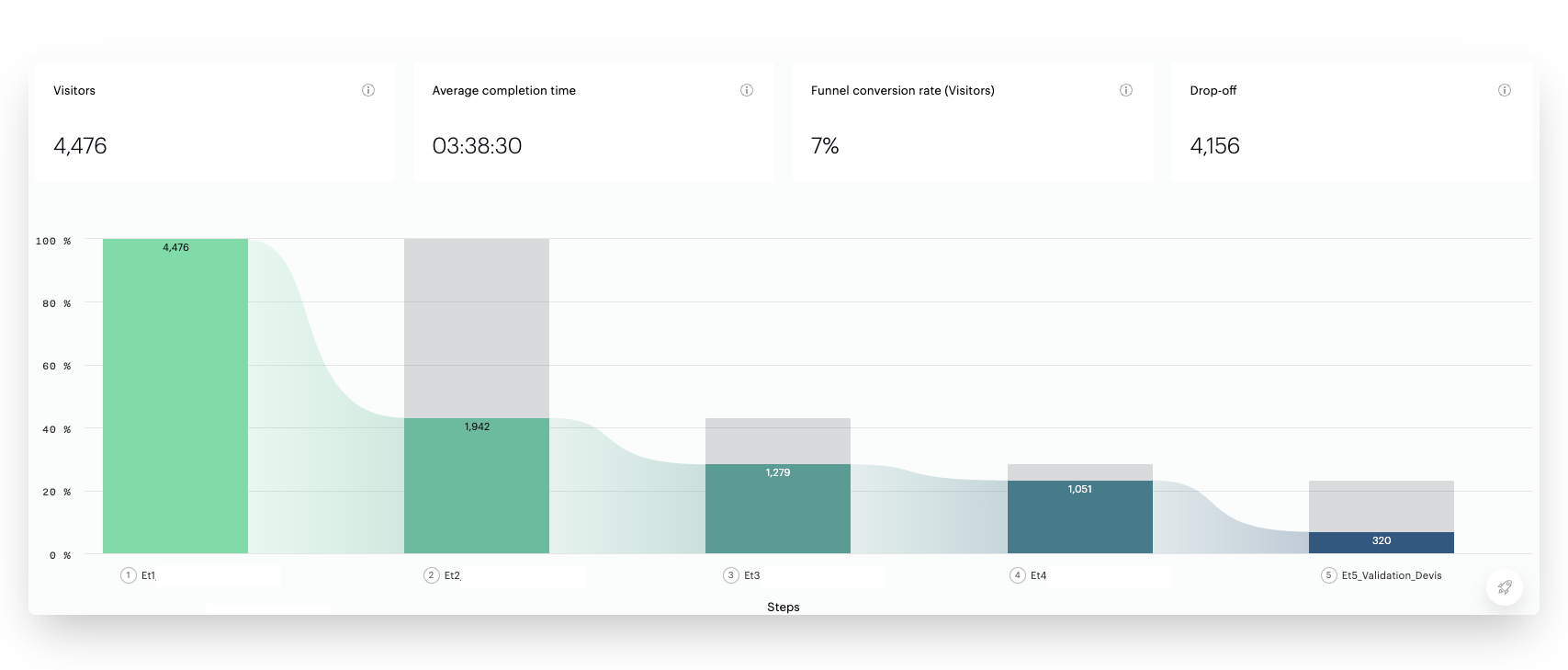

Les premiers résultats mettent en évidence des ruptures significatives dans le parcours :

- 57 % des utilisateurs quittent le parcours entre l’étape 1 et l’étape 2,

- 34 % supplémentaires abandonnent entre l’étape 2 et l’étape 3,

- 18% quittent le funnel entre l’étape 3 et l’étape 4

- La chute la plus marquée intervient à la fin : 70 % des utilisateurs qui atteignent l’étape 4 ne finalisent pas la demande.

Identification des points de friction

⚠️ Lecture critique

Avant de tirer des conclusions hâtives, il est essentiel de recontextualiser ces pertes à la lumière du contenu du funnel.

Certaines ruptures sont fréquentes — voire attendues — dans ce type de parcours :

- L’étape 1 agit souvent comme un point d’entrée non filtré, susceptible de capter des utilisateurs non qualifiés ou simplement curieux,

- Les étapes contenant des information attendue (comme un prix indicatif) peuvent déclencher un abandon dès lors que cette information été obtenue,

- Enfin, la saisie des coordonnées personnelles reste historiquement l’étape la plus sensible, générant mécaniquement un taux de sortie élevé.

Ces éléments doivent être pris en compte pour établir des hypothèses robustes et cibler les étapes qui justifient une investigation approfondie.

A la lumière de ces constats, l’attention se porte sur la perte observée sur l’étape 2 et l’étape 3 où 34% des utilisateurs quittent le parcours. L’utilisateur a manifesté une intention claire, mais ne poursuit pas vers les étapes d’après.

- Inadéquation entre les besoins de l’utilisateur et le contenu de l’étape : les options affichées ne correspondent pas aux attentes ou aux besoins.

- Problèmes techniques liés à certains environnements de navigation : bugs d’affichage sur mobile, incompatibilités avec certains OS ou navigateurs, éléments non interactifs.

- Frictions UX invisibles : chargement lent, hiérarchie visuelle confuse, trop grand nombre d’options ou absence apparente de résultats.

- Attente non satisfaite : l’utilisateur espérait obtenir une information immédiate (prix, conditions, délai) qui ne lui est pas présentée à cette étape.

- Manque de personnalisation perçue : les suggestions de besoins paraissent génériques ou peu adaptées, ce qui peut générer un désengagement rapide.

- Effet de dissonance : l’utilisateur se rend compte, à cette étape, que l’offre ne répond pas à son besoin initial (conflit entre besoin exprimé et produits disponibles).

- Répétition ou redondance perçue dans les champs ou questions posées, pouvant générer une sensation de lourdeur ou d’étape inutile.

L’analyse segmentée qui suit vise à tester certaines de ces hypothèses en isolant les utilisateurs concernés, puis à les qualifier par l’observation comportementale.

Création et analyse d’un segment ciblé

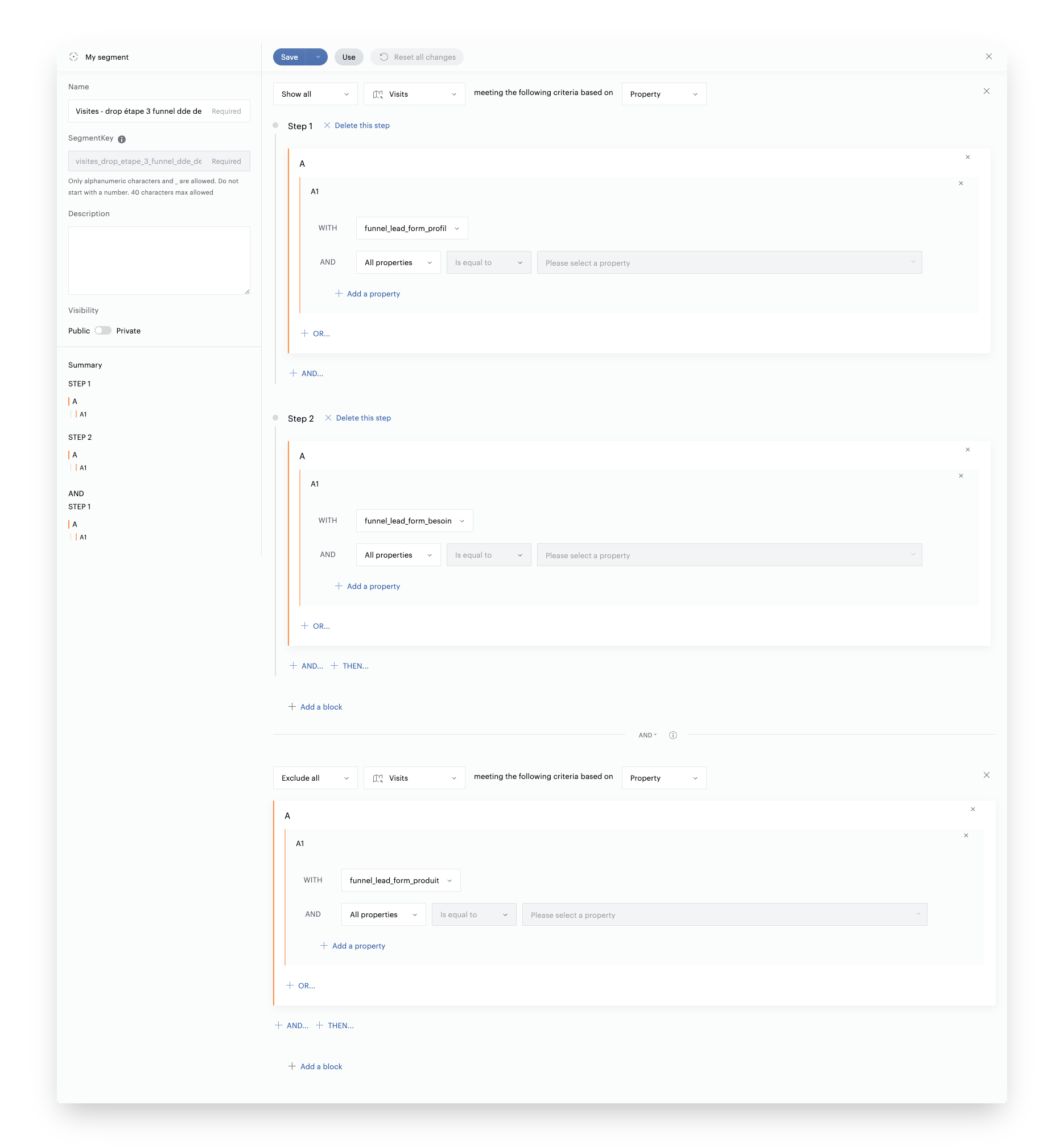

Afin de qualifier plus finement la rupture identifiée entre l’étape 2 et l’étape 3, un segment ciblé a été construit dans Piano Analytics. Il repose sur la définition suivante :

- Inclusion : les visites ayant déclenché l’événement d’affichage de l’étape 1 puis l’étape 2

- Exclusion : les visites ayant poursuivi jusqu’à l’affichage de l’étape 3

Ce segment permet d’isoler les utilisateurs qui quittent le parcours après avoir exprimé un besoin, sans consulter les produits. Il constitue la base d’une analyse plus qualitative et contextuelle.

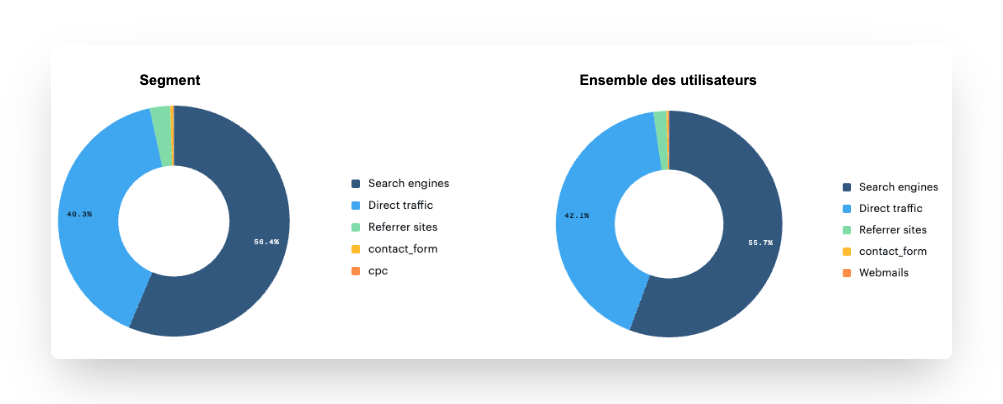

Une première série de croisements est effectuée pour identifier d’éventuelles sur-représentations ou anomalies, en comparaison avec la population globale du funnel :

- Source de trafic : un écart significatif peut orienter vers une promesse mal alignée en amont (ex. : surreprésentation de campagnes d’acquisition peu qualifiées, ou d’un canal en particulier).

- Environnement technique : une concentration sur certains navigateurs, OS ou devices peut révéler des problèmes d’affichage ou de compatibilité sur l’étape 3.

- Variables métier (custom) : croisement avec les données collectées en amont (informations déclarées à l’étape 1) pour détecter une inadéquation systématique entre le profil utilisateur et les éléments proposés aux étapes d’après.

Ce travail de segmentation vise à identifier des patterns récurrents au sein de la population sortante. Il permet ensuite de formuler des hypothèses ciblées, qui pourront être confirmées ou infirmées par l’observation des sessions correspondantes dans Clarity.

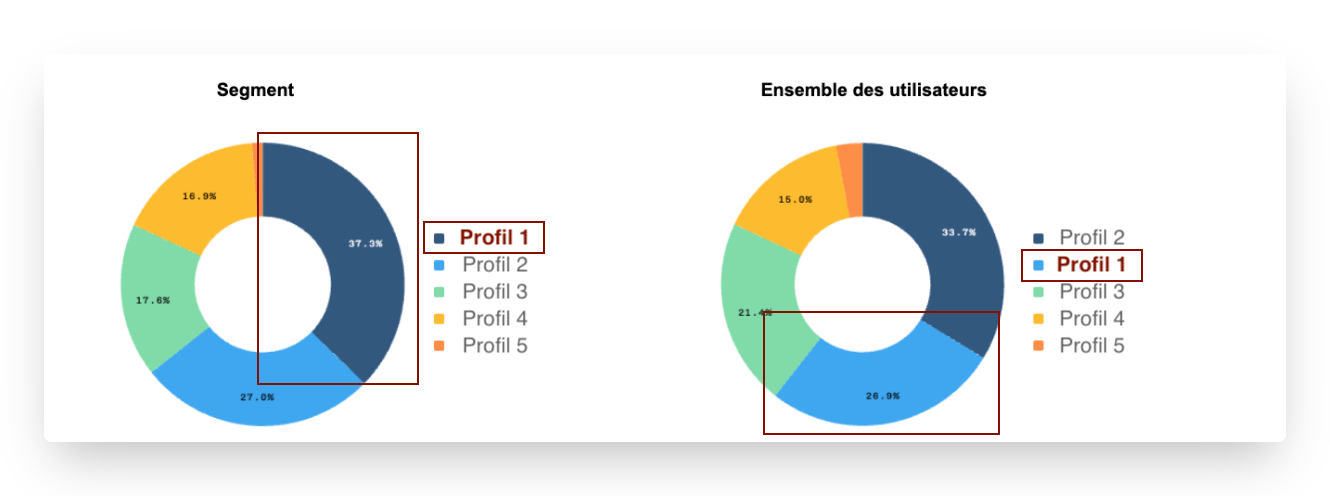

- Les utilisateurs du Profil 1 sont sur-représentés dans le segment où on observe le drop : 37.3% vs 26.9%, soit une différence de 10.4pts soit +38%

- Hypothèse : les utilisateurs du Profil 1 ne trouveraient pas d'option correspondant à leur besoin et auraient des difficultés à passer à l’étape 3 ?

-

Pas d’écart représentatif

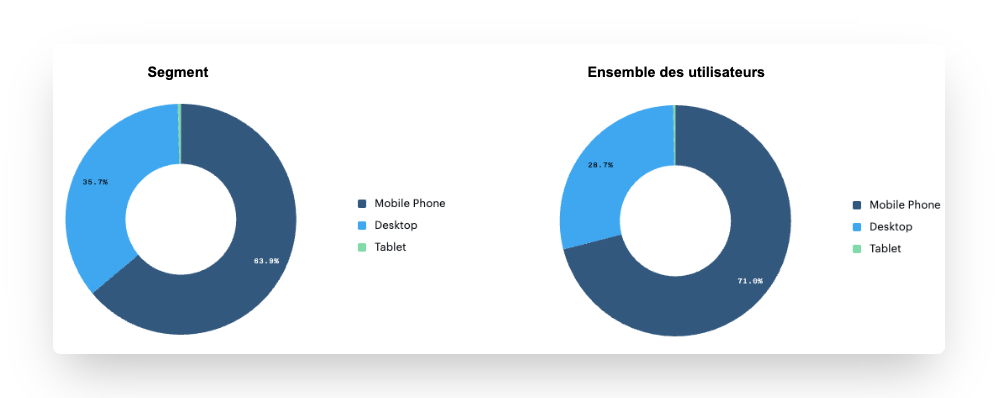

- Les utilisateurs Desktop semblent plus nombreux sur notre segment : on identifie un écart de 7.1pt soit une différence de 10%

- Hypothèse : les utilisateurs Desktop rencontrent-ils des difficultés techniques sur l’étape de sélection du besoin ?

Afin d’aller au-delà de la lecture quantitative, les hypothèses issues du segment ciblé doivent être confrontées à l’analyse comportementale réelle. L’objectif ici est d’observer directement les sessions des utilisateurs sortants, afin de confirmer ou d’infirmer certaines causes probables d’abandon.

Pour ce faire, un pont a été mis en place entre Piano Analytics et Microsoft Clarity, via l’identifiant utilisateur, et uniquement pour les utilisateurs ayant donné leur consentement.

Les identifiants “User ID” ne peuvent être collectés qu’avec le consentement de l’utilisateur. En particulier, ils ne peuvent pas être collectés sous le régime de l’exemption (cf. guide de l’exemption CNIL pour Piano Analytics). Il faut donc s’assurer de collecter le Clarity User ID uniquement en mode de consentement Opt-in sur Piano Analytics.

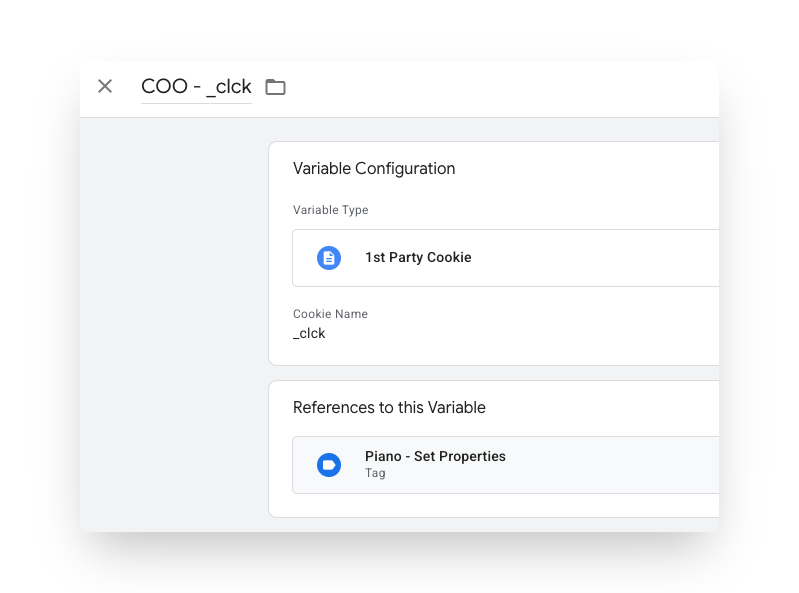

Implémentation technique : un paramétrage spécifique a été

réalisé dans Google Tag Manager pour récupérer la valeur du cookie Clarity User ID (stocké sous la clé _clck) déposée par Clarity sur le

navigateur de l’utilisateur.

Cette valeur est ensuite envoyée dans Piano via une propriété personnalisée clarity_user_id, intégrée dans le setProperties.

Grâce à ce dispositif, il devient possible de récupérer directement les Clarity User IDs associés à un segment donné dans Piano, puis de les utiliser pour filtrer les enregistrements de session dans Clarity.

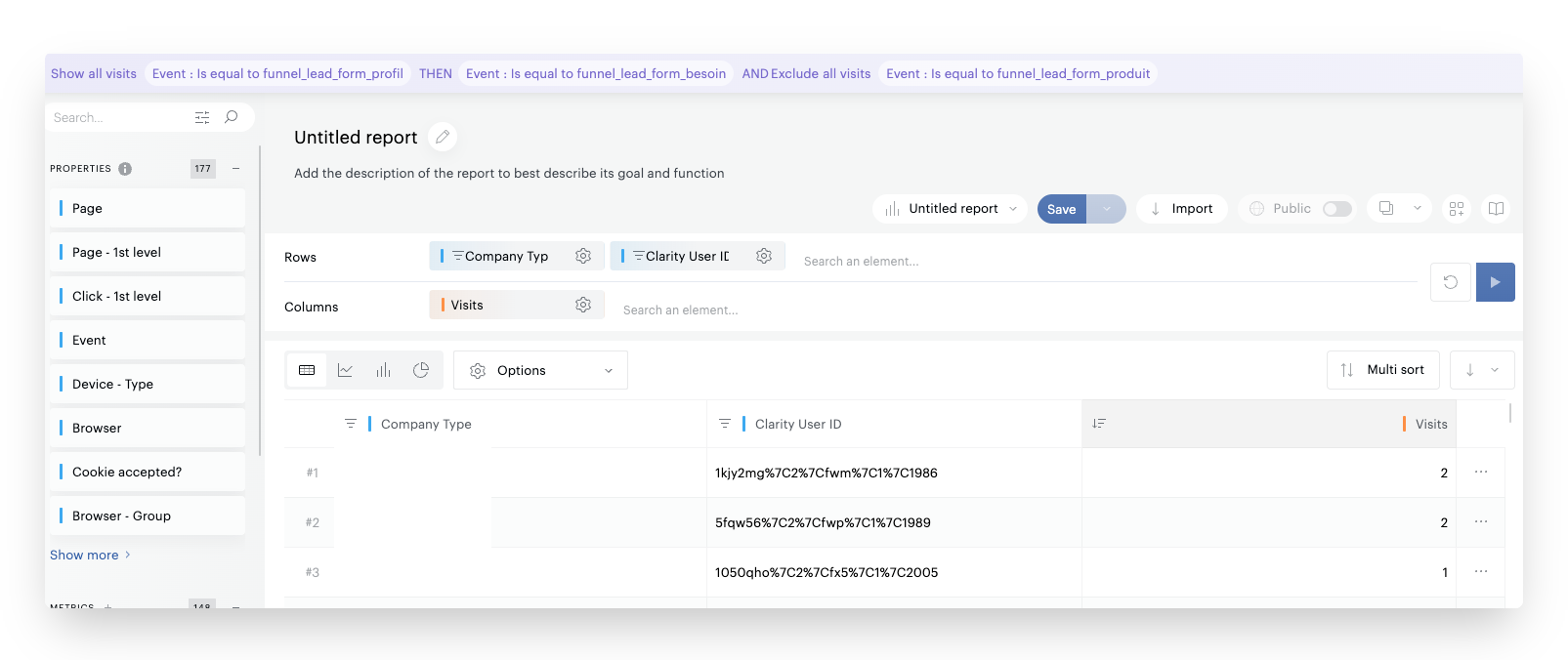

Au vu de la déperdition marquée observée sur le segment des utilisateurs ayant déclaré un Profil 1, on propose de poursuivre prioritairement sur cette population. Les Clarity User IDs associés à ce segment sont extraits depuis Piano, grâce au paramétrage décrit ci-dessus, afin de permettre une observation qualitative ciblée dans Clarity.

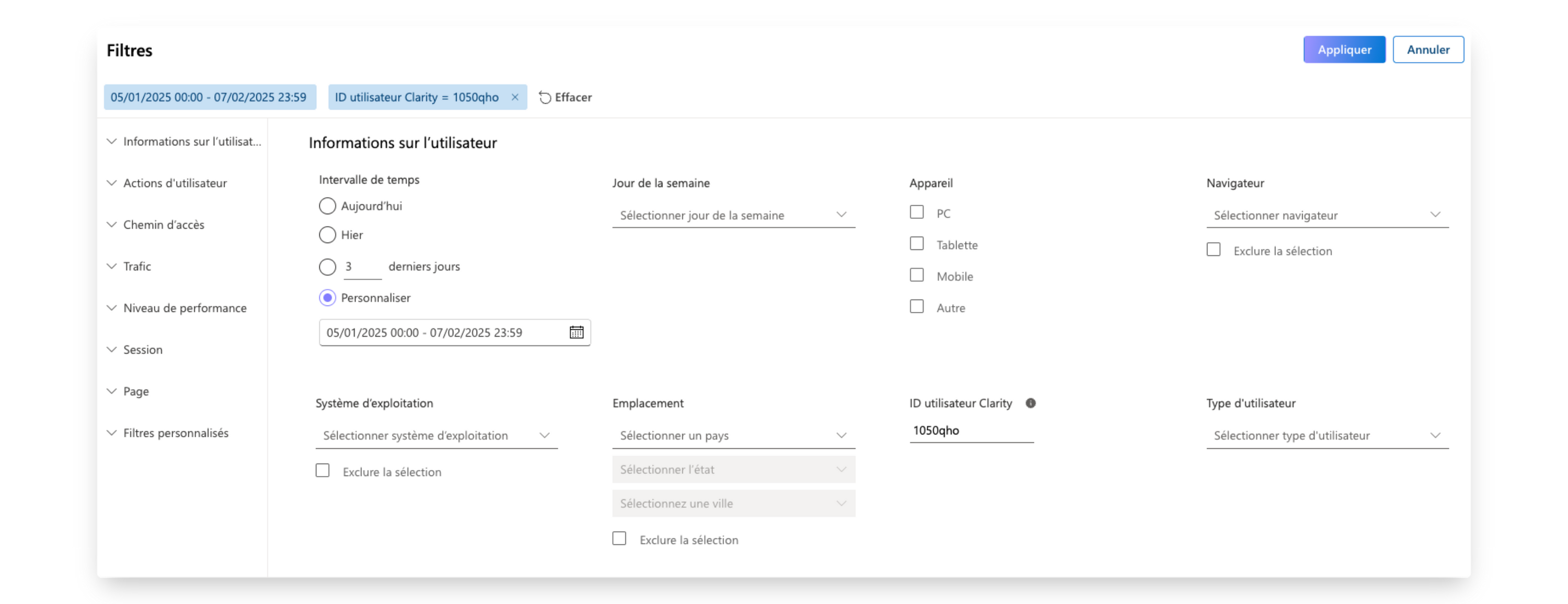

Une fois la liste restreinte de Clarity User IDs identifiée (idéalement 10 à 30 utilisateurs), ces valeurs sont utilisées pour filtrer les sessions dans l’interface Clarity.

À noter : l’identifiant Clarity remonté dans Piano est encodé avec

d’autres métadonnées techniques, sous la forme d’une chaîne de type 1050qho%7C2%7Cfx5%7C1%7C2005. Une fois décodée, elle donne 1050qho|2|fx5|1|2005. Seuls

les 6 à 7 premiers caractères correspondent au véritable Clarity user ID

utilisé dans l’interface de recherche Clarity. Ce traitement est à

effectuer avant d’utiliser les identifiants pour filtrer les sessions.

Un volume de 10 à 30 visites constitue généralement un bon compromis : suffisamment large pour faire émerger des motifs récurrents, mais assez restreint pour permettre une analyse manuelle approfondie. Au-delà, le risque est de multiplier les observations anecdotiques ou de perdre en efficacité sans gain significatif en robustesse analytique.

Analyse qualitative sur Microsoft Clarity : validation comportementale

La phase suivante consiste à valider ou invalider les hypothèses posées à partir des données Piano, en observant les comportements réels des utilisateurs concernés via Microsoft Clarity. Ici, on veut donc répondre à l’hypothèse : “Les utilisateurs du Profil 1 ne trouvent pas d'option correspondant à leur besoin réel”

Ciblage des sessions à observer

Grace au travail en amont, il nous suffit de filtrer le sessions dans l’outil Clarity pour n’analyser que les visites correspondant à notre segment (via le Clarity User ID)

Validation des hypothèses via le comportement

L’objectif de cette étape est de confronter les hypothèses formulées à la réalité des interactions. Plusieurs comportements récurrents peuvent ainsi être observés :

- Allers-retours répétés entre les étapes 1 et 2, suggérant une incompréhension sur le chemin attendu ou une difficulté à faire correspondre le profil au besoin,

- Modifications multiples d’un paramètre à l’étape 1, indiquant une hésitation sur la catégorie à sélectionner, ou une classification mal comprise,

- Arrêt brutal après affichage de l’étape 2, parfois sans clic, ce qui peut suggérer un problème d’affichage ou une inadéquation perçue de l’offre,

- Temps de chargement élevé, éléments non interactifs, rage clicks ou scrolls rapides, autant de signaux faibles d’une friction technique ou ergonomique.

Chaque session visionnée dans Clarity doit faire l’objet d’un commentaire structuré, permettant de conserver une trace exploitable de l’observation. Cette étape est essentielle pour formaliser les constats, favoriser la relecture croisée, et alimenter les échanges avec les équipes produit ou UX.

Voici les retours sur les 4 premières sessions analysées :

| Clarity User ID | Commentaire |

|---|---|

| 1050qho | Retourne sur l’étape précédente, puis quitte le funnel |

| 107naxa | Reste sur l’étape besoin 10 secondes puis ferme la fenêtre |

| 10c3gkx | Retourne sur l’étape précédente, choisit un autre type d’entreprise, puis ferme la fenêtre sur l’étape besoin après quelques secondes |

| 10n9e12 | Retourne sur l’étape précédente, choisit un autre type d’entreprise, puis ferme la fenêtre sur l’étape besoin après quelques secondes |

| etc. |

Après un échantillon de 20 sessions ciblées, plusieurs comportements récurrents ont été identifiés :

- Plus de la moitié des utilisateurs ont effectué un retour à l’étape précédente après l’affichage de l’étape 2.

- Parmi eux, une majorité ont modifié leur profil, suggérant un doute ou une insatisfaction sur le profil initialement sélectionné.

- En parallèle, environ 20 % des utilisateurs quittent le funnel très rapidement (moins de 10 secondes après affichage de l’étape 2)

- Tandis que l’on observe sensiblement le meme volume d’utilisateurs qui restent entre 30 secondes et 1 minute, sans interagir davantage.

Ces éléments convergent vers deux pistes principales :

- Inadéquation perçue entre le profil sélectionné et les produits affichés à l’étape suivante, incitant certains utilisateurs à revenir en arrière pour “tester” un autre profil.

- Attente non comblée à l’étape 2, possiblement liée à une absence de réponse immédiate à leur besoin (ex. : produit spécifique attendu), générant un abandon rapide.

Prochaines étapes recommandées

Ces constats pourront servir de base à des recommandations UX ciblées (ex : clarification des profils en étape 1, feedback immédiat en étape 2, micro-indicateurs de continuité vers les produits), et/ou à des tests de variation sur l’enchaînement des étapes.

Structurer, capitaliser, et répliquer la démarche

La valeur de ce type d’analyse repose autant sur la pertinence des observations que sur la capacité à structurer et capitaliser les enseignements. Il est essentiel de documenter de manière rigoureuse :

- les hypothèses formulées à chaque étape,

- les segments analysés dans Piano,

- les observations issues du visionnage Clarity.

- les recommandations et actions découlant de l’analyse

Cette structuration facilite le partage entre équipes produit, data et UX, et permet de passer d’un diagnostic ponctuel à une démarche réplicable.

Nous recommandons l’usage d’un template unique (type Google Sheets ou Notion) centralisant tous les éléments listés plus haut.

Ce format facilite la priorisation des chantiers à tester, en mettant en évidence les causes fréquentes, les signaux faibles et les cas isolés.

Conclusion : une approche robuste et transversale

Une approche structurée et des leviers d’optimisation directement actionnables

Cette étude illustre l’intérêt d’une approche croisée entre données analytiques et observation comportementale, appliquée à un parcours multi-étapes de demande de devis (lead).

Elle permet de dépasser une simple lecture des taux de conversion pour comprendre, de manière concrète, où, comment et pourquoi les utilisateurs décrochent.

En croisant les fonctionnalités de Piano Analytics (funnel, segments, propriétés personnalisées) avec les enregistrements Clarity, on est en mesure de :

- formuler des hypothèses tangibles,

- les valider ou les rejeter par l’observation,

- proposer des leviers d’optimisation directement actionnables.

Une méthodologie applicable à d’autres cas

Cette démarche peut être transposée :

- à d’autres outils analytics (ex: Google Analytics),

- à d’autres outils de CRO behavioral analytics (ex: Contentsquare, Hotjar, Mouseflow,…),

- et à de nombreux autres parcours : formulaires, tunnels ecommerce, simulateurs, ou onboarding d’applications.

Dès lors qu’un parcours présente une déperdition partielle et une segmentation disponible, ce type d’analyse offre un cadre robuste pour identifier les irritants réels et prioriser les améliorations.